Search Analytics for Sheetsのアップデート内容を確認・解説

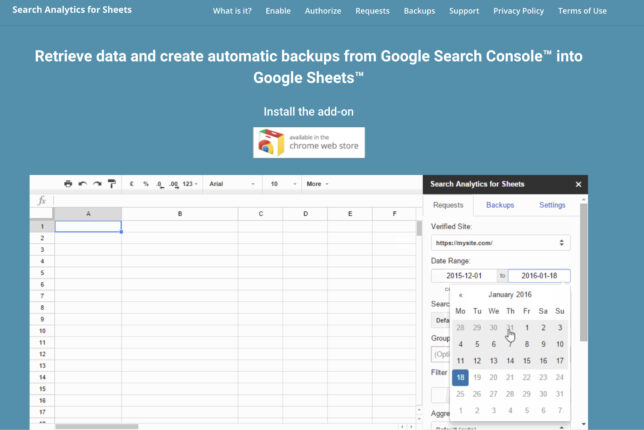

みなさんはSearch Analytics for Sheetsを使っていますか?

スプレッドシートのアドオンで、サーチコンソールのデータを出力してくれることができます。

サーチコンソールは最大1,000件しかデータを出力できません。

小規模なサイトであればそれだけで問題ないのかもしれませんが、中規模、大規模サイトになってくると1000件の出力では物足りなくなってきます。

Search Analytics for Sheetsでは出力されるデータに限度がないため、大規模サイトのSEO担当者は重宝することでしょう。

2022年Search Analytics for Sheetsのアップデートが実施されましたので、その内容を解説していこうと思います。

更新内容原文と翻訳

Faster requests, append mode, URL inspection, and other improvements!

Faster requests using the Sheets API v4

A lot of the fetching and writing data to the spreadsheet when making requests has been moved from the standard Sheets Apps Script service to the much faster Sheets API.This should make requests significantly faster, especially when they're returning large amounts of data.

Append mode now available for requests

You can now choose whether to replace the entire sheet when requesting data, or to append the data to the end of the sheet. Keep in mind you should stick to the same dimension groups when appending data.First iteration of URL inspection is here!

This has been one of the features that I've been on the fence about adding, since it's not really "Search Analytics" data. However, since URL inspection is incredibly useful, especially when paired with performance data (thanks Aleyda for pointing that out!), I went ahead and added the option to the requests form.Keep in mind this is still a beta feature, and as such it has certain limitations:

It currently only works when grouping by the 'Page' dimension alone.

The request needs to use the "Replace" mode for a given sheet.

It's slow. Takes 5-10 seconds per URL, about one minute per batch of 10 URLs (it's currently batching to minimize time taken to write the results). In theory you can ask for data for hundres of URLs, but that would mean spending a lot of time waiting. This will likely be resolved with parallel requests.

Results aren't cached. As such, if you request data for the same URL multiple times, it will count towards your daily quota of 2,000 URLs. This is also one of the reasons why the feature only works with the 'Page' dimension alone.

Other improvements

Using the URL Inspection features means a lot more time is needed to run the request. Since there's a 6 minute limit on the time spent processing a single request on the server side, part of the request logic was moved on the client side.One of the main benefits of this change is that large requests that would retrieve more than 25,000 rows will now be split into multiple requests, with each request writing its data into the sheet separately. This means that if, for some reason, the API errors out, you can still keep the partial data retrieved so far.

Also, status notifications of the requests have also changed to provide more updates as the entire request gets processed, instead of only one message at the end of the request process. For large requests, you'll see every time a batch of 25,000 rows have been retrieved, and you'll also get notified for each batch of URL Inspection data.

引用:https://searchanalyticsforsheets.com/

以下がDeepLで翻訳してもらった文になります。

リクエストの高速化、アペンドモード、URLインスペクションなどの改善

Sheets API v4によるリクエストの高速化

リクエストを行う際のデータの取得とスプレッドシートへの書き込みの多くが、標準のSheets Apps Scriptサービスから、より高速なSheets APIに移行されました。これにより、特に大量のデータを返すようなリクエストは大幅に高速化されるはずです。

リクエストに追加モードが追加されました

データをリクエストする際に、シート全体を置き換えるのか、シートの最後にデータを追加するのかを選択できるようになりました。データを追加する際は、同じディメンジョングループにこだわる必要があることに留意してください。URL検査の最初のイテレーションが登場

これは、「検索アナリティクス」のデータではないので、追加することに躊躇していた機能の1つでした。しかし、URL検査は、特にパフォーマンスデータと組み合わせた場合に非常に有用であるため(ご指摘いただいたAleydaさんに感謝します!)、リクエストフォームにオプションを追加することにしました。これはまだベータ版の機能であり、一定の制限があることを覚えておいてください。

現在、「ページ」ディメンジョンだけでグループ化する場合のみ機能します。

リクエストは、指定されたシートの「置換」モードを使用する必要があります。

動作が遅い。1つのURLにつき5-10秒、10URLのバッチで1分程度かかります(現在は結果の書き込みにかかる時間を最小限にするためにバッチ処理をしています)。理論的には数百のURLのデータを要求することができますが、それは多くの時間を待つことを意味します。これはおそらく並列リクエストで解決されるでしょう。

結果はキャッシュされません。そのため、同じURLのデータを複数回リクエストすると、1日のノルマである2,000URLにカウントされます。これは、この機能が「ページ」ディメンジョンだけで機能する理由の一つでもあります。

その他の改善点

URL検査機能を使用すると、リクエストの実行に多くの時間が必要になります。サーバー側で1つのリクエストを処理する時間は6分に制限されているため、リクエストロジックの一部はクライアント側に移動されました。この変更の主な利点のひとつは、25,000行以上を取得するような大きなリクエストは、複数のリクエストに分割され、それぞれのリクエストが別々にシートにデータを書き込むようになったことです。これにより、何らかの理由でAPIがエラーになった場合でも、これまでに取得した部分的なデータを保持することができるようになりました。

また、リクエストのステータス通知も、リクエスト処理の最後に1つのメッセージだけでなく、リクエスト全体が処理されるにつれて、より多くの更新情報を提供するように変更されました。大規模なリクエストの場合は、25,000行のバッチが取得されるたびに表示され、URL検査データのバッチごとに通知されるようにもなります。

追記:バックアップは今のところ何も変更されていません。

近日中のアップデートにご期待ください。

翻訳:https://www.deepl.com/ja/translator

データの出力速度がアップ

Sheets Apps Scriptサービスから、より高速なSheets APIに移行されたことによりデータの出力速度が上昇したようです。

出力行数によっては待ち時間がかなり発生していたので、これは素直に嬉しいですね。

といっても体感どれくらい速くなったのかは正直分かりません。

何回か出力してみて、言われてみれば少し速くなったかなと思える変化です。

下詰め更新に対応

Search Analytics for Sheetsの出力は今まで2種類ありまして、1つは新規シートにデータを出力する方法と、アクティブになっているシートの中身を全て消して出力し直す方法がありました。

今回のアップデートにより既存のシートに下詰めでデータを出力することができるようになりました。

今まで同じことをしようと思ったらAppスクリプトで無理やり下詰めするか、手作業でコピペをする必要がありました。

注意点として、ディメンションのグループを一致させる必要があります。

残念だったのは、定期実行には対応していないことです。

毎日定期的に昨日のデータを出力する使い方をしたい人もいると思うのですが、こういった使い方には対応していないようです。

カラムの不一致やどのシートに出力するのかなど問題点はありそうですが、ぜひ定期実行にも対応して欲しいところです。

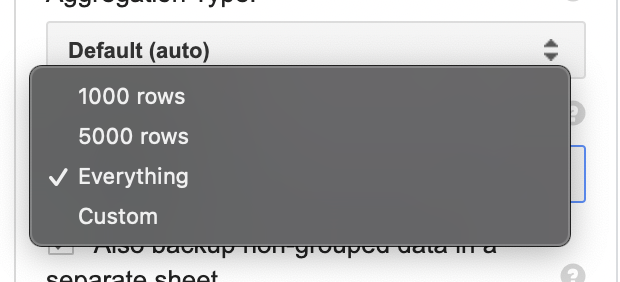

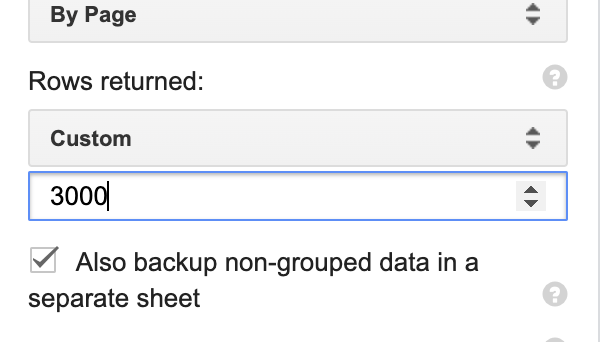

出力する行数のカスタムが可能に

出力できる行数をカスタムできるようになりました。

今までは1000,5000,無制限の3種類からしか選ぶことが出来ず、多過ぎたり、少な過ぎたりという感じで使い勝手が悪かったです。

地味ですが、これで中規模のサイトの運営者は無駄な待ち時間が発生せずに済むので良改善だと思いました。

URL検査のデータを出力可能に

サーチコンソールのクリックやインプレッションと一緒にURL検査の指標を監視している人は多いと思いますが、この度URL検査の結果も同時に出力できるようになりました。

内容としては「URL Inspection API」で出力できるものと同じですね。

これにより、別々に出していたデータをマージする必要がなくなります。

URL検査のデータは検索アナリティクスとは別物なのでこの機能を実装することに関して躊躇していたとツール製作者の方は書いています。

なので、この機能はベータ版のようで、今後改良が加えられていくと思います。

試しに出力してみると以下のカラムが追加された出力されました。

各項目についての説明も加えておきます。

- URL Inspection Result(Googleにインデックスされているかどうか)

- Coverage(インデックスのカバレッジ)

- Robots.txt(robots.txtで制御されていないかどうか)

- Indexing(noindexされていないかどうか)

- Last Crawled(最終クロール日)

- Fetch Status(最終クロール日のページの状況)

- Google Canonical(Googleが選んだ正規化先のURL)

- User Canonical(ユーザーがcanonicalで指定している正規化先のページ)

- Crawled As(Googlebotの種類(主にSPbotになるはず))

- AMP Result(AMPページが用意されていればそのURL)

- AMP Issues(AMPエラーが出ていないか)

- Mobile Result(モバイルフレンドリーに対応しているページかどうか)

- Mobile Issues(モバイルフレンドリーに関するエラーが出ていないかどうか)

- Rich Results(リッチリザルトの構造化マークアップが有効かどうか)

- Rich Results Valid(ページにある構造化マークアップの種類)

- Rich Results Warning(マークアップの警告があるか)

- Rich Results Error(マークアップにエラーがあるか)

- Search Console Link(ページ別のURL検査のサーチコンソールのURL)

このデータをどう扱うか、ですが、個人的に便利だと思ったのは「Google Canonical」の項目と「Last Crawled」の項目です。

canonicalはSEOでよく使うタグではありますが、強制力がなく、実際に効いているかどうかは実装して様子をみないとわからないのが欠点です。

一つ一つURL検査かけるのは手間なので、これは使ってみたいと思える機能の一つです。

「Last Crawled」は施策をリリースしてからクローラーが回ってきたかどうかを確認するのに使えそうです。

注意点としては出力数に制限があることで、

- 1日に2000クエリまで

- 1分間に600クエリまで

という制約があります。

大規模サイトの場合、これでは足りないと思いますが、ご利用は計画的に。

URL Inspection API の技術的な仕様に関しては、

こちらを参照ください。